语言模型评测应采用哪些方法?

![]() 游客

2025-04-22 17:38:01

32

游客

2025-04-22 17:38:01

32

在当前人工智能与自然语言处理的快速发展中,语言模型作为其核心技术之一,正受到学术界与工业界的广泛关注。语言模型的评测对于衡量模型性能、推动技术进步、以及指导实际应用具有重要意义。本文将探讨如何科学、全面地进行语言模型评测,旨在为研究者、开发者和用户提供一套参考方法。

1.明确评测目的和指标

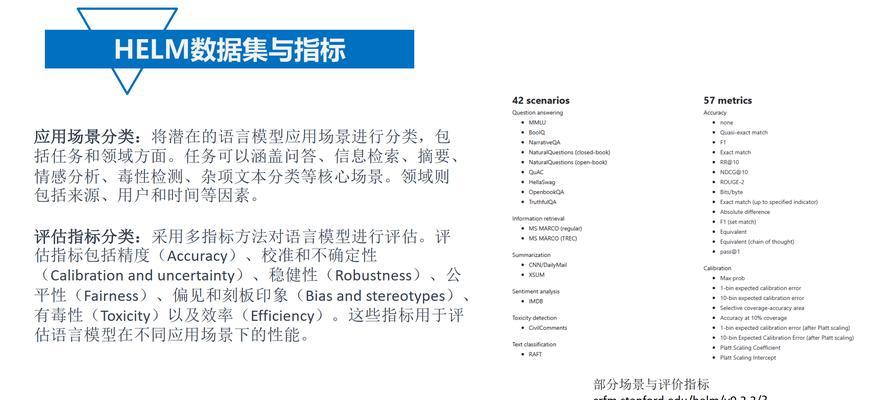

在开始评测之前,首先需要明确评测的目的和指标。评测目的可能包括但不限于理解模型的泛化能力、生成文本的流畅性和合理性、以及模型对特定任务的适应性。而评测指标则包括准确率、召回率、F1分数、困惑度(Perplexity)等,它们能够从不同维度反映模型性能。

2.构建标准测试集

3.采用多维度评估方法

3.1自动评估

自动评估方法通常通过计算模型输出与标准答案之间的差异来评估模型性能。在自然语言理解任务中,常见的自动评估指标有BLEU、ROUGE、METEOR等。在语言生成任务中,困惑度是一个重要指标,它衡量模型对下一个单词的预测能力。

3.2人工评估

尽管自动评估方法在效率和一致性上具有优势,但人工评估不可或缺。人工评估可以评估文本的质量、流畅度和语义的准确性,例如通过问卷调查或专家评审的方式,对生成文本的自然度、相关性和信息准确性进行评分。

3.3对比基准模型

为了更好地理解模型性能,通常需要将模型的评测结果与当前领域的基准模型进行对比。这不仅能够体现模型在技术上的进步,还能帮助开发者定位模型的不足之处。

4.综合应用实际应用场景

真实世界的语言模型应用远比评测场景复杂。将模型部署到实际的应用场景中进行评测,可以更准确地把握模型在现实环境中的表现和潜在问题。

5.持续跟踪与更新

语言模型的评测并非一次性的,随着模型和应用场景的不断更新,评测方法也需要持续跟踪最新的技术和需求进行调整和优化。

6.常见问题解答

在进行语言模型评测时,研究者和开发者可能会遇到以下问题:

Q1:如何保证测试集的多样性和代表性?

A1:构建测试集时应考虑涵盖各种语言风格和应用场景,同时保证数据的多样性与质量。使用公开的基准测试集如GLUE、SuperGLUE等,可作为参考。

Q2:人工评估是否具有主观性?

A2:是的,人工评估存在主观性,但通过制定明确的评分标准和增加评估样本数量可以有效降低主观性对结果的影响。

Q3:如何平衡自动评估与人工评估的权重?

A3:这取决于评测的具体目标。通常在初步筛选阶段使用自动评估快速评估大量模型,而在深入分析阶段加入人工评估,以获取更全面的评价。

通过上述评测方法的介绍,我们希望为语言模型的评价提供一个系统化的视角。综合运用这些方法,可以全面、深入地理解模型性能,为研究和应用提供有力的参考依据。

在语言模型评测的过程中,不断更新和改进评测手段,以适应不断进步的技术和变化的应用需求,是推动整个领域前进的关键。未来,随着更多的创新方法和技术的涌现,语言模型评测将会更加精细化、专业化。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自火星seo,本文标题:《语言模型评测应采用哪些方法?》

标签:

- 上一篇: 用户画像分析模型如何构建?

- 下一篇: 数据库是什么?它在数据管理中扮演什么角色?

- 搜索

- 最新文章

- 热门文章

-

- 营销网站搭建记录怎么写?记录哪些关键步骤和注意事项?

- 如何上正规网站推广呢?有哪些有效的推广策略?

- 可以编写html的文件有哪些?它们各自有什么特点?

- 抖音怎么搜索关键词?搜索技巧有哪些?

- 营销型网站权重低怎么办?提升网站权重的有效策略是什么?

- 书吧网站设计分析怎么写?有哪些关键要素需要考虑?

- 营销网站怎么推广效果最佳?有哪些有效策略?

- 购物网站行情分析怎么写?如何准确把握市场趋势?

- 新网站如何推广宣传方案?有哪些有效的策略和步骤?

- 论坛SEO优化在2024年的新策略?

- 专业网站设计的标准是什么?

- 快手文案中关键词加虚线的意义和作用是什么?

- 如何做招聘网站免费推广?有效策略有哪些?

- 淘宝关键词成交率分析方法是什么?

- 免费音频素材网站有哪些?如何选择高质量的音频资源?

- 2024年SEO优化:哪种评论形式最有利于提升搜索引擎排名和用户信任?

- 淘宝补单关键词选择方法?提升补单效果的关键词?

- 企业网站模板选择对SEO有何影响?如何选择以优化SEO?

- 怎么问人家一网站分析?网站分析的常见问题有哪些?

- HTML表格属性有哪些?如何正确使用它们?

- 热门tag

- 标签列表